В этой статье я расскажу о том, почему необходимо создать файл robots txt, и как его правильно составить.

В этой статье я расскажу о том, почему необходимо создать файл robots txt, и как его правильно составить.

Правильный robots txt – один из важных моментов поисковой оптимизации, необходимой для продвижения сайта в топ.

Одной из функций файла является запрет индексации всех лишних страниц блога.

В robots.txt задается также адрес sitemap.xml (карты сайта) и прописывается его главное зеркало (с www или без www).

Поисковые системы один и тот же веб ресурс с www и без www воспринимают, как разные сайты. Обнаружив, что их содержимое ничем не отличается, поисковики «склеивают» домены.

Чтобы этого не происходило, рекомендуется в файле robots.txt обозначить главное зеркало.

Объясню на примере своего сайта. Если набрать в браузере адрес сайта с www.seitostroenie.ru, то вас перебросит на этот же сайт, но без www.

До перехода на сайт

После перехода на сайт

Значит, для моего сайта главное зеркало – без www. Надеюсь, понятно объяснила.

Пример правильного robots.txt для моего сайта на WordPress

В этом файле от индексации закрыты все те разделы, которые не должны учитываться поисковыми системами. Все это надо прописать в текстовом документе с расширением .txt, то есть, дать файлу название robots.txt. Только, не забудьте, поменять seitostroenie.ru на данные своего сайта.

Затем этот файл надо разместить в корне блога, в ту же папку, где находится wp-content.

А теперь рассмотрим более подробно, что означают в документе каждая из строк.

User-agent: * — создание правила для всех поисковиков;

User-agent: Yandex – для Яндекса;

Запретить доступ роботов к разделам:

Disallow: /

Чтобы задать основное зеркало блога прописываем:

Host:

Адрес карт сайта, Sitemap, созданных при помощи плагина Google XML Sitemaps прописываем в двух последних строчках.

Проблемы с индексацией

Если на сайте не настроены ЧПУ, то с индексацией могут быть проблемы:

Строка — Disallow: /*?* закрывает от индексации такие страницы, так как ссылки на эти посты выглядят примерно так: site.ru/?p=665. Чтобы это исправить, удаляем эти строчки.

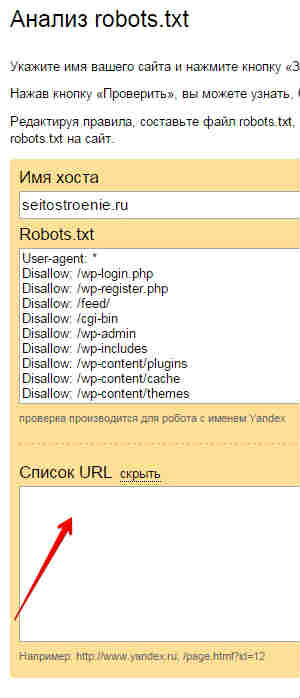

Проверка robots.txt

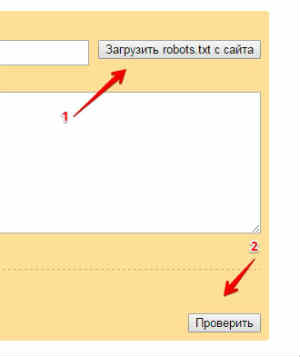

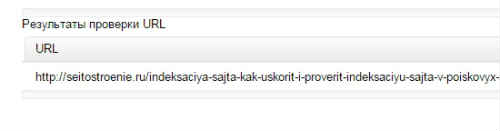

Идем в Яндекс Вебмастер и в разделе «Анализ robots.txt» вписываем адрес сайта

и нажимаем “Загрузить robots.txt с сайта”, появится следующее сообщение:

В графу “Список URL” добавляем адрес статьи, чтобы проверить, не стоит ли запрет на ее индексацию. Жмем на кнопку «Проверить».

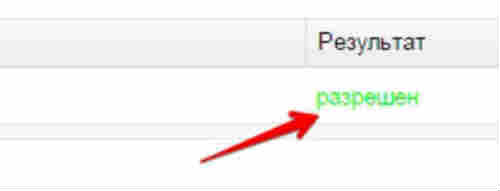

Получаем результат, что все в порядке:

Надеюсь, что данная статья была Вам полезной. Если у Вас есть какие-либо дополнения, поделитесь ими в комментариях.

Для Рунета самой часто встречающейся задачей является создание файла robots.txt для Яндекса , так как сейчас Яндекс – самая популярная поисковая система. Важно уметь правильно использовать директиву Host , которую соблюдает этот поисковик.