В сегодняшней статье речь пойдет о том, какие могут быть допущены ошибки при оптимизации сайтов.

Ведь порой бывает так, что вроде бы все сделано правильно, ресурс регулярно наполняется контентом: новыми статьями, графикой, видеоматериалами, а почему то не продвигается в результатах поиска, плохо индексируется, имеет уязвимости.

В чем же дело? Что сделано неправильно? Как исправить допущенные недочеты?

При подготовке ресурса к сео-продвижению могут быть допущены ошибки технического плана и seo. Разберем их и выясним, с чем они могут быть связаны.

Технические

Основные технические ошибки оптимизации сайта следующие:

- Доступность ресурса в любое время суток. Не всегда вебмастера обращают внимание на этот момент. Если сайт какое-то время, даже, если это всего лишь несколько минут в день, недоступен, то этот фактор может привести к тому, что ресурс будет понижен в поисковой выдаче. Почему так происходит? Да, потому что как раз в этот момент, когда ресурс был недоступен, мог на сайт зайти поисковый робот для сбора статистики, которая в данное время имела не очень хорошие показатели. Чтобы быть уверенным в регулярной доступности сайта можно поставить на ресурс ЯндексМетрику и отслеживать статистические данные.

- Наличие дубликатов страниц. Это одна из серьезных ошибок, когда одна и та же страница сайта доступна по разным адресам. Часто это вызвано особенностями движка. Чтобы их не было, перед тем, как начать продвижение сайта, необходимо правильно настроить индексацию, прописав в файле robots.txt те страницы, которые надо и нельзя индексировать, а также это можно сделать с помощью тега <noindex></ noindex> и атрибута rel =“nofollow”. Как это сделать читайте здесь и тут.

- Ошибки ответа сервера. При слабом хостинге или выборе дешевого тарифа сервер может плохо справляться с нагрузками, приводя к недоступности сайта. На начальных этапах создания ресурса данная проблема может не давать о себе знать, т.к. сам ресурс еще не будет иметь веса. Но при большой посещаемости, например одномоментном заходе на сайт сотни человек, сервер не сможет выдержать нагрузку. В результате ресурс станет недоступен для посетителей. Если проблема только в этом, то следует изменить тариф, а при высоком трафике придется воспользоваться выделенным сервером.

- Ошибки 404, 501, 502. Таких ответов сервера не должно быть. Обязательно необходимо сделать анализ, почему это происходит, и устранить проблемы.

- Наличие циклических ссылок. То есть не должно быть на странице таких ссылок, которые будут перенаправлять на эту же страницу. Часто можно видеть на странице кликабельный заголовок, который перенаправляет посетителя на этот же контент, но только под другим адресом. Это является ошибкой и в данном случае требуется исправление.

- Глубина вложенности страниц не должна превышать трех уровней. Т.е. страница должна находиться от главной не более, чем два или три уровня. При наличии более глубокой вложенности может быть затруднена индексация ресурса поисковыми ботами.

- Наличие медленно загружаемых страниц. Их необходимо найти и проверить код страницы на наличие ошибок и неоптимизированной графики.

- Наличие мусора в коде. Необходимо проверить код и его соотношение с контентом. Последний должен занимать не менее 30% по отношению к исходному коду.

- Отсутствие проиндексированных страниц. Их также необходимо проверить, поскольку они могут служить источником технических ошибок, неуникального контента или низкого его качества.

SEO ошибки оптимизации сайтов

- Для полноценного продвижения сайта не менее 95% страниц должны быть проиндексированы поисковыми роботами. Очень часто бывает так, что страницы вроде бы как проиндексированы, но в поиске их нет. Необходимо работать с такими страницами. Значит, были допущены ошибки оптимизации контента на данных страницах сайта.

Их необходимо своевременно находить и исправлять. Такое может произойти с контентом на тех страницах, которые уже устарели, так как их уже могли много раз скопировать и разместить на других веб ресурсах. Также отсутствие может быть связано с наличием ошибок в тексте и его низкой уникальностью. В таком случае следует переписать текст и дополнить его более актуальной информацией.

- В корневой директории сайта должен находиться файл robots.txt, в котором следует указать всем поисковикам (yandex, гугл, mail), а также рекламным ботам от ЯндексДирект и Google Adsense, какие страницы необходимо индексировать, а какие – запретить.

- Наличие карты сайта для поисковых роботов xml и для пользователей в формате html. Она не должна быть закрыта от индексации.

- Наличие одного заголовка Н1 и подзаголовков Н2, Н3 …Н6 или хотя бы несколько Н2. Если они отсутствуют, то их надо добавить, так как это помогает структурировать контент.

- Наличие тега Strong на странице помогает посетителю быстрее находить нужную информацию. Переспам тегом недопустим. Strong оправдывает себя только в том случае, если выделены важные для пользователя мысли. Выделять лучше не отдельные слова, а предложения.

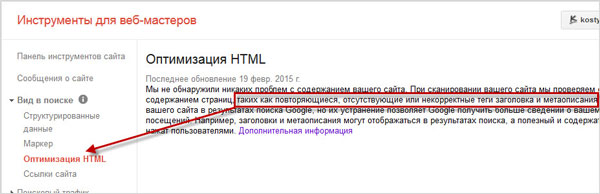

- Наличие мета-тегов title, description, keywords, но они не должны повторяться. Информацию по оптимизации можно посмотреть в вебмастере Гугла. Также необходимо придерживаться длины этих мета-тегов.

- Проверьте файл txt через вебмастер Яндекса и Гугла не закрыты ли от индексации нужные страницы, так как при закрытии одних случается, что выпадают из индекса другие страницы.

- Необходимо проверить сайт на наличие исходящих ссылок, а если они имеются и вы не хотите их убирать по какой-то причине, то необходимо удостовериться, что это качественные ресурсы. Если эти сайты некачественные, то от ссылок лучше избавиться.

- Если вы используете бесплатный шаблон сайта, то велика вероятность наличия исходящих линков, которые также необходимо убрать.

- При написании текста не стоит акцентировать внимание на ключевых фразах с помощью выделения их тегами strong и em.

- Тошнота контента на странице не должна превышать 4%, т.к. текст становится не только плохо воспринимаемым, но и водянистым.

Переоптимизация может стать причиной попадания ресурса под санкции поисковых систем.

Теперь вы знаете, какие основные ошибки возможны при оптимизации веб ресурса. Как найти и устранить некоторые из них, я уже рассказывала в предыдущих статьях. Читайте, если остались вопросы, задавайте в комментариях.